近日,自然语言处理领域国际权威学术会议EMNLP公布论文接收结果,智慧芽的论文被EMNLP 2025成功录用。该论文题为《CRAB: A Benchmark for Evaluating Curation of Retrieval-Augmented LLMs in Biomedicine(CRAB:生物医药领域检索增强型大模型内容遴选能力评测基准)》。智慧芽论文被国际权威学术会议收录标志着公司在AI与生物医药交叉领域的研究成果获得国际学术界认可。

图:收录情况

EMNLP(Empirical Methods in Natural Language Processing)是自然语言处理(NLP)领域具有影响力的国际学术会议之一,专注于实证方法驱动的 NLP 研究,涵盖从基础算法到应用落地的全链条探索。EMNLP 成立于 1996 年,由 ACL(国际计算语言学协会)下属的 SIGDAT主办,在学术影响力上仅次于ACL。

智慧芽在论文中提出了专门用于评估生物医学领域检索增强型大模型在内容遴选方面能力的多语言评测基准CRAB,覆盖英语、法语、德语和中文四个语种。CRAB聚焦“内容遴选能力(curation ability)”——即大模型在回答生物医药问题时,能否引用真正相关的参考、并有效过滤无关或噪声信息。通过纳入一种新颖的基于引用的评估指标,CRAB量化了检索增强型大模型在生物医学领域的内容遴选性能。实验结果揭示了主流大模型在该项能力上存在差异,强调了在生物医学领域改进该能力的迫切需求。

Part.01

如何评测内容遴选能力?

随着检索增强技术(RAG)在生物医药领域应用中展现出巨大潜力,如何可靠地评估大模型的内容遴选能力已成为关键挑战。该能力是指大模型在增强检索到的参考文献时,能够识别和引用相关参考文献,同时忽略不相关参考文献的能力。这一过程涉及模型根据检索语料库中参考文献的相关性和可靠性进行选择、整合和引用。

与市面上现有的评测基准不同,CRAB创新地采用"基于引用"的评测方法,通过检验模型生成答案时的实际引用行为来量化其内容遴选能力,共设计了三个核心指标——相关参考证据引用准确率(Relevance Precision, RP)、无关参考证据抑制率(Irrelevance Suppression, IS)以及总体遴选效率(Curation Efficiency, CE)——以F1值的形式计算衡量“能否引用对的、能否排除错的、整体把握是否稳健”。

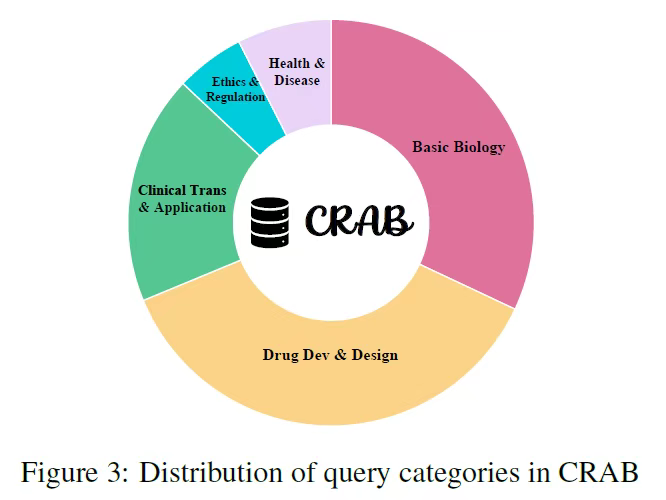

为更贴近真实业务场景,CRAB采用开放式问题设计,并对每个问题提供可控比例的“相关/无关”参考材料。基准共包含约400个生物医药开放问题,配套2467条相关参考与1854条无关参考,覆盖基础生物学、药物研发与设计、临床转化与应用、伦理与监管、公共卫生与传染病等关键主题。部分样本问题特意保留“无可检有效参考”的情形,以模拟真实检索缺口。数据来源包括PubMed和Google搜索结果,通过LlamaIndex实现检索。

图表:CRAB评测基准中五大问题类型分布

Part.02

评测结果与关键发现

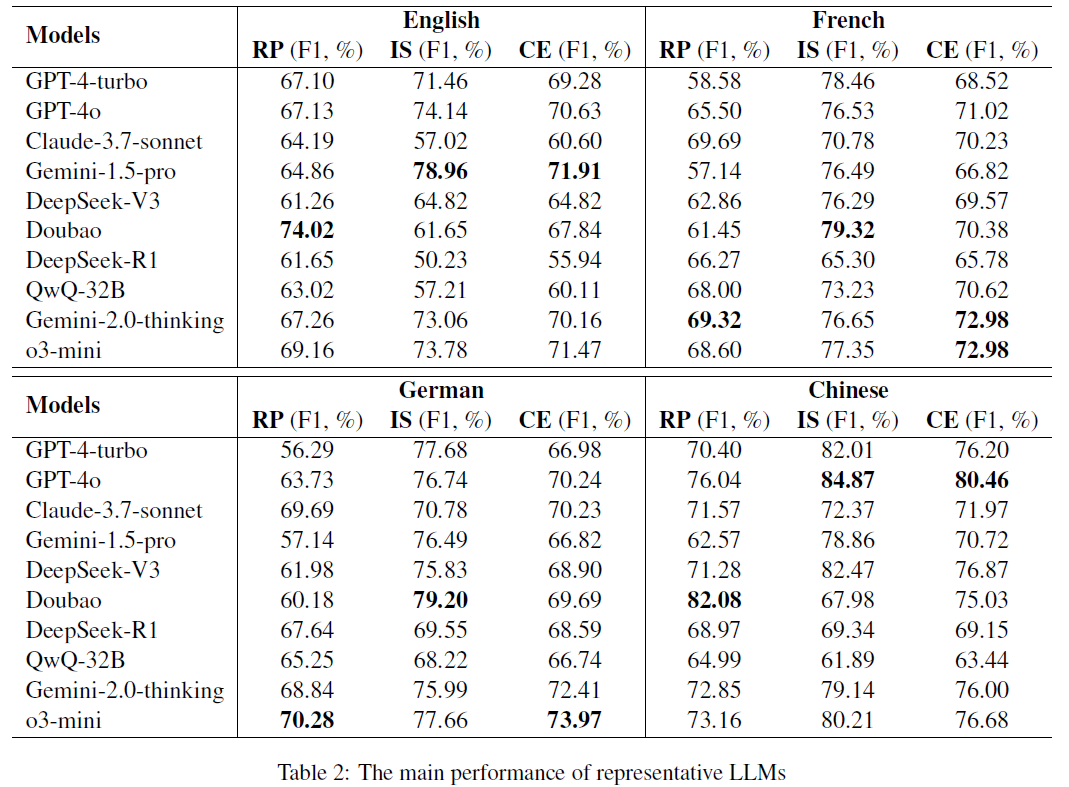

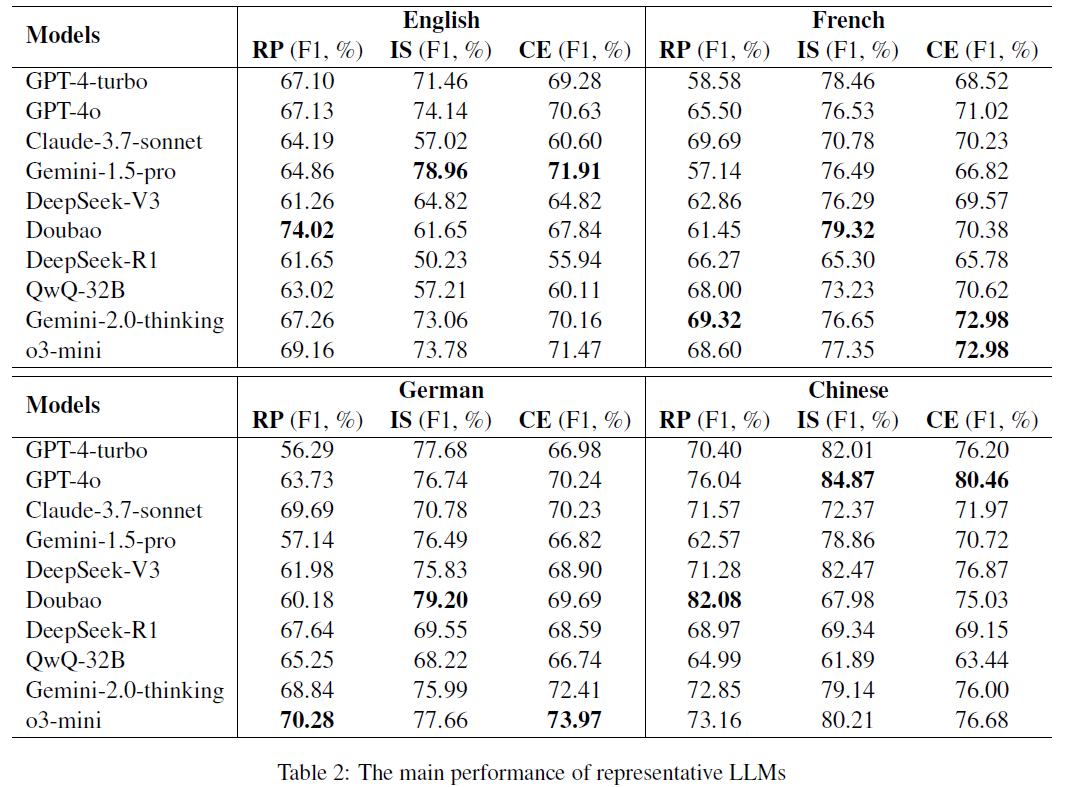

智慧芽基于CRAB对包括GPT-4-turbo、GPT-4o、Claude-3.7-sonnet、Gemini-1.5-pro、DeepSeek-V3、Doubao、DeepSeek-R1、QwQ-32B、Gemini-2.0-thinking、o3-mini等在内的共10个主流通用大模型和推理大模型进行了系统性评测,实验结果如下:

图表:参与评测实验的大模型主要表现

发现1:闭源大模型展现出更稳定的性能

评测结果显示:主流通用大模型在内容遴选性能上存在的显著差异,并展示出明显的语言特定性能模式:如在中文表现上,GPT-4o的性能表现最佳,内容遴选效率(CE F1得分)高达80.46;在英语表现上,Gemini-1.5-pro表现优越(CE F1得分71.91);在法语和德语的罗曼语系表现上,o3-mini性能领先(法语CE F1得分72.98,德语CE F1得分73.97)。

综合来看,闭源大模型由于其更大的参数规模和更广泛的多语言预训练知识,相比于开源大模型,其整体表现更为稳定。

发现2:部分推理大模型表现不如同源基础模型

评测显示,部分主流的推理LLMs(如DeepSeek-R1和QwQ)在生物医药内容遴选方面的性能表现不及预期,甚至低于其同源基础模型。

研究发现,这些模型因在数学和代码任务上的强化训练,在处理生物医药问题时出现"过度思考"——过度推演导致对部分相关或无关参考的误用,影响了专业概念边界的准确把握。

发现3:通过垂直领域训练可显著提升内容遴选能力

为验证大模型的改进潜力,智慧芽以Llama3-70B为样本,对其进行了持续预训练(CPT)和监督微调(SFT)的验证实验。结果显示,通过CPT加深对生物医学知识的理解后,模型的CE F1分数从基线的58.42提升至69.23(CPT)和73.58(SFT),证明了大模型证据遴选能力具有显著的改进潜力。

值的一提的是,在上述三大关键发现之外,智慧芽为验证本评测基准实验的准确性,在英语数据集上邀请人类专家进行核验。结果显示,CRAB的自动评测与专家人工评测在RP、IS、CE三个指标上的一致性分别达到92.3%、89.7%和91.5%,证实了该评测方法的可靠性。

在生物医药领域,准确的参考内容引用直接关系到临床决策、药物研发和患者安全。CRAB通过量化评估模型的证据遴选能力,为构建可信、可追溯的生物医药AI系统提供了统一标准。这对于临床辅助决策、药物信息检索、医学文献综述、监管合规等应用场景具有重要价值。智慧芽推出CRAB基准,旨在推动生物医药AI向更加可靠、可验证的方向发展。目前,CRAB数据集已在Hugging Face社区上开源,欢迎学术界和产业界共同使用和改进。

智慧芽始终致力于以AI等前沿技术赋能企业创新发展。此次在生物医药AI领域取得的突破性研究成果,不仅有助于推动检索增强型大模型在专业领域的应用质量,更将进一步提升智慧芽AI产品的技术能力和服务品质,帮助客户在海量生物医药信息中实现更精准的洞察挖掘和更高效的决策支持。展望未来,智慧芽将继续突破技术边界、优化产品体验,为科技创新注入新动能。